国际医疗器械展览会Medtec重磅消息!全球首个法案出台,引领医疗AI走向大模型时代

2024-04-30

国际医疗器械展览会Medtec获悉,欧盟《人工智能法案》已经正式出台,从市场监管立法的高度,为整个人工智能产业链各利益相关方提供了一个合规义务框架,以规范人工智能的开发和使用。法案实施后将对全球人工智能产业链产生深远影响,值得中国企业关注,并与中国市场目前的医疗人工智能软件监管规定做对照。

当地时间2024年3月13日,欧洲议会以压倒性多数通过了世界上第一个全面的人工智能法律框架——欧盟《人工智能法案》(下称“法案”)。

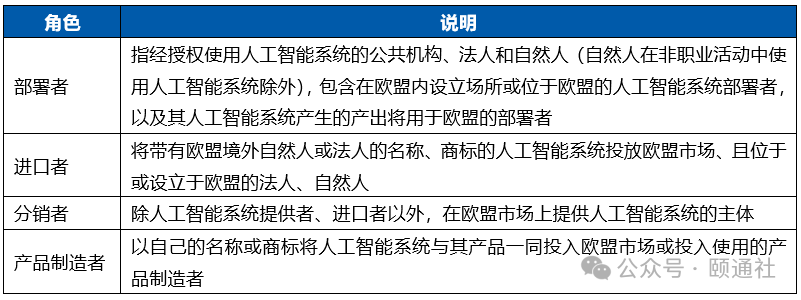

01 适用范围

人工智能合规性是对人工智能系统内部实施的全面监督,确保其在整个开发、部署和使用过程中遵守法律要求和道德规范。具体包括:

-

监管评估,以确保在开发、部署和使用人工智能系统的过程中遵守法律。这不仅包括遵守人工智能法律,还包括遵守《通用数据保护条例》(GDPR)规则和版权规范等。

-

道德标准,包括公平、透明、负责和尊重用户隐私。伦理合规涉及识别人工智能系统中的偏见、防止隐私泄露以及最大限度地降低其他伦理风险。

-

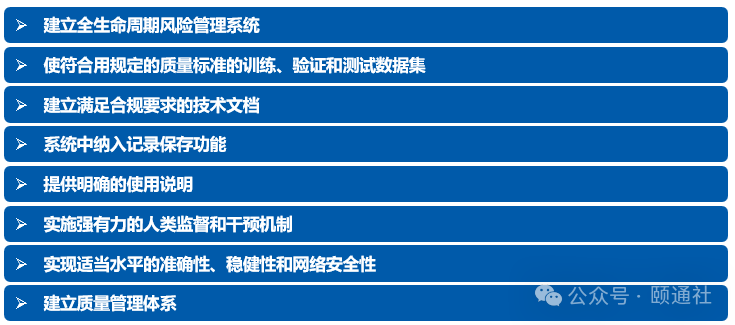

系统架构:应用程序基础设施的详细图表和说明,包括如何收集、处理和安全存储用户数据。

-

数据处理政策:概述在整个应用程序生命周期中如何处理用户数据的文档,包括数据收集方法、加密协议和数据保留政策。

-

人工智能算法:描述应用程序中用于分析用户数据和生成运动建议的人工智能算法,包括算法如何训练和验证的信息。

-

隐私和安全措施:详细说明应用程序隐私和安全功能的文档,如用户同意机制、访问控制以及防止未经授权访问或数据泄露的措施。

-

遵守法规:遵守相关法规和标准的证据,如美国的《健康保险可携性和责任法案》(HIPAA)或欧盟的《通用数据保护条例》(GDPR),包括为验证合规性而进行的任何认证或审核。

-

患者互动:记录人工智能系统根据患者输入或医疗数据提供诊断或建议的每个实例。

-

系统更新:记录为提高性能或解决问题而对人工智能算法或软件进行的任何更新或修改。

-

诊断结果:记录人工智能系统提供的每项诊断结果,包括诊断是否准确或是否需要进一步检测或干预。

-

不良事件:指出人工智能系统的诊断或建议导致不良后果或对患者造成伤害的任何情况。

-

系统性能:长期跟踪人工智能系统的性能指标,如准确率、假阳性/阴性率和响应时间。

-

安全访问和登录人工智能系统的分步程序,包括基于角色和职责的认证要求和用户访问级别。

-

向人工智能系统界面输入病人数据和上传医学影像扫描的指南,确保符合数据隐私法规,如《健康保险可携性与责任法案》(HIPAA)或《通用数据保护条例》(GDPR)。

-

关于如何解释和验证人工智能系统输出结果的说明,包括评估系统预测和建议可信度的标准。

-

在患者病历中记录人工智能系统使用情况的规程,包括系统生成的任何相关发现、建议或警报。

-

建议将人工智能系统融入现有的临床工作流程和决策过程,最大限度地减少干扰,并确保医疗保健专业人员与人工智能技术之间的无缝协作。

-

提供培训资源和材料,让医疗服务提供者了解与使用人工智能系统相关的功能、局限性和潜在风险,强调持续教育和技能开发的重要性。

(6)实施强有力的人类监督和干预机制,确保人工智能系统在做出关键医疗决策时不会取代人类的判断。

例如,考虑设计一个高风险人工智能系统,以协助医疗服务提供者根据皮肤科图像诊断皮肤癌。为了确保人类的监督和干预,可以实施以下机制:

-

决策支持警报:对人工智能系统进行编程,以标记其诊断可信度低于某一阈值或诊断不确定的病例。在这种情况下,系统会提示医疗服务提供者查看人工智能的诊断结果,并做出临床判断。

-

第二意见审查:如果人工智能诊断与医疗服务提供者的初步评估存在不确定性或分歧,医疗服务提供者可以选择要求人类专家或专家小组提供第二意见。

-

审计跟踪和日志记录:人工智能系统可以对其决策过程进行详细的审计跟踪,包括每项诊断建议背后的理由、用于分析的输入数据以及人工审查员所做的任何调整。这些信息将被记录下来,供医疗保健专业人员审查和核实。

-

紧急超驰功能:在需要立即采取行动的紧急情况或危及生命的情况下,人工智能系统可包含紧急超驰功能,允许医疗服务提供者绕过人工智能的建议,根据自己的临床判断做出决定。

-

持续监测和反馈:人工智能系统可纳入持续监测和反馈机制,医疗服务提供者可报告系统使用过程中遇到的差异、错误或不良结果。这种反馈回路将促进人工智能算法的不断改进和完善。

-

准确性:人工智能系统应使用各种具有代表性的心脏图像数据集、患者记录和临床结果进行严格的验证和测试。应不断改进和优化人工智能算法,以逐步提高诊断准确性。例如,该系统可利用在超声心动图、心电图和其他心脏成像模式的大型数据集上训练的深度学习技术来达到较高的准确性。 -

鲁棒性:人工智能系统的设计应能在各种实际条件和场景下可靠运行,包括患者人口统计学、成像质量和疾病表现的差异。鲁棒性可通过采用数据增强、模型组装和对抗训练等技术来实现,以增强系统对输入数据中的噪声、伪造和不确定性的适应能力。此外,系统还应包括故障安全机制和错误处理程序,以减轻意外故障或失灵的影响。 -

网络安全:保护患者数据并确保医疗保健信息的保密性、完整性和可用性对于人工智能系统的安全运行至关重要。应实施强有力的网络安全措施,以防止未经授权的访问、数据泄露和网络威胁。这可能包括对静态和传输中的敏感数据进行加密、实施访问控制和身份验证机制、定期进行安全审计和渗透测试。

-

文件控制:管理所有开发文件,确保准确性和可访问性。

-

变更管理:严格评估和批准系统变更,以保持安全性和有效性。

-

风险管理:在系统的整个生命周期内识别、评估和降低风险。

-

培训:为员工提供软件开发、质量原则和法规方面的培训。

-

审计:定期进行内部和外部审计,确保合规和持续改进

-

所有 GPAI 模型提供者必须提供技术文档和模型使用说明,遵守版权法,并公开说明用于训练人工智能的内容。

-

不构成系统性风险的GPAI 模型的提供者必须遵守版权法,并公布总结的培训数据。

-

所有构成系统性风险的 GPAI 模型(无论是开放式还是封闭式)的提供者必须进行模型评估、监控和报告涉及人工智能模型的严重事故,并确保网络安全保护。