【独家】医疗器械领域人工智能技术的发展

2021-04-20

人工智能在医疗机械中的应用正在不断增加。尽管还没有具体的指令或监管框架,但AI决策仍然需要加以理解和验证,以确保患者的安全。TÜV SÜD分享了医疗科技领域人工智能的多个重要方面。

2020年1月初,世界卫生组织(WHO)发布了中国武汉类流感疾病的特殊病例信息。然而早在2019年12月1,一家专门通过人工智能监测传染病传播的加拿大公司就警告客户说中国有疫情风险。这一警告来自对网络上动物和植物疾病新闻报道和文章的AI分析。对全球飞机票数据的访问让AI能够准确预测病毒出现数日后的传播情况。

缺乏监管框架

这个示例揭示了AI和机器学习(ML)的能力。这两者都越来越多地被运用于医疗器械之中,比如以集成电路的形式。尽管使用AI同样有风险,但常用标准和规范尚未包含对这些创新技术的具体要求。比如欧盟的医疗器械法规(MDR)仅提出了一般性软件要求。根据规定,必须按照当前技术水平、为目标用途开发和生产软件。

这也适用于AI,必须确保功能的可预见性和可重复性,这反过来又需要经过验证和确认的AI模型。软件标准IEC 62304和IEC 82304-1就提出了验证和确认要求。但是传统软件和搭配机器学习的人工智能仍然有根本上的区别。机器学习基于使用数据训练模型,而不是对流程进行明确的编程。随着训练的进行,模型会通过改变“超参数”不断改善和优化。

测试AI训练数据和定义范围

数据质量是AI进行预测的关键。常见问题包括监督机器学习模型中的偏差、模型过度或低度拟合以及标签错误。测试揭示了这些问题,

并显示偏差和标签错误常常是缺乏多样性的训练数据无意识导致的。以一个被训练用于识别苹果的AI模型为例。如果用于训练模型的数据主要是不同形状和大小的青苹果,模型可能会将绿色的梨子认成苹果却无法识别红苹果。在特定环境下,某些方面无意识的共同特性可能被AI视为重要特性,尽管它们毫不相关。数据的统计分布必须做出合理调整,以符合真实环境。比如,AI在识别人类时,两条腿不应被视为关键因素。

标签错误也可能是主观性(“疾病严重程度”)或标识符不适合模型用途导致的。为大量数据贴上标签并选择合适的标识符是一个需要大量时间和成本的流程。有时只有很少一部分数据会进行人工处理,用于训练AI,然后指示AI标签剩余数据。这个过程并不能保证没有错误,也就是说错误会重复出现。

成功的重要因素就是数据质量和使用的数据量。目前,根据经验估计一个算法所需的数据量少之又少。虽然基本上只要数据的质量和数量足够高,即便是简单的算法也能发挥良好的作用,但大多数情况下能力受限于(标签)数据的可用性和计算能力。所需数据的最小范围取决于问题和AI算法的复杂度,非线性算法所需的数据要多于线性算法。

通常70-80%的可用数据用于训练模型,其他数据用于验证预测。用于AI训练的数据应涵盖特性的最大带宽。

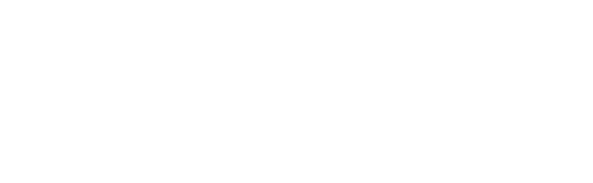

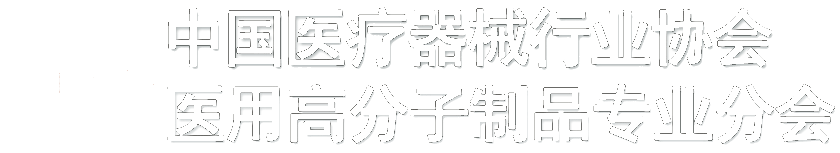

示例:识别膝盖骨关节炎

黑盒AI显示,以下图片所属的两位患者中的一人将在未来三年发展成膝盖骨关节炎。这是人眼看不到的,诊断无法确认。患者还会选择手术吗?(以下图片来自Spectrum IEEE.org在2018年8月发表的“Making Medical AI Trustworthy”(让医疗AI更加可信) [https://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=8423571],最初来自Osteoarthritis Initiative [https://nda.nih.gov/]。这篇文章反映的是作者的观点,不一定代表NIH或将初始数据提交到Osteoarthritis Initiative的研究人员的观点或看法。)

上图:图1.这位患者在未来3年不会患上骨关节炎。

上图:图1.这位患者在未来3年不会患上骨关节炎。

图:图2.这位患者将在未来3年患上骨关节炎。

图:图2.这位患者将在未来3年患上骨关节炎。

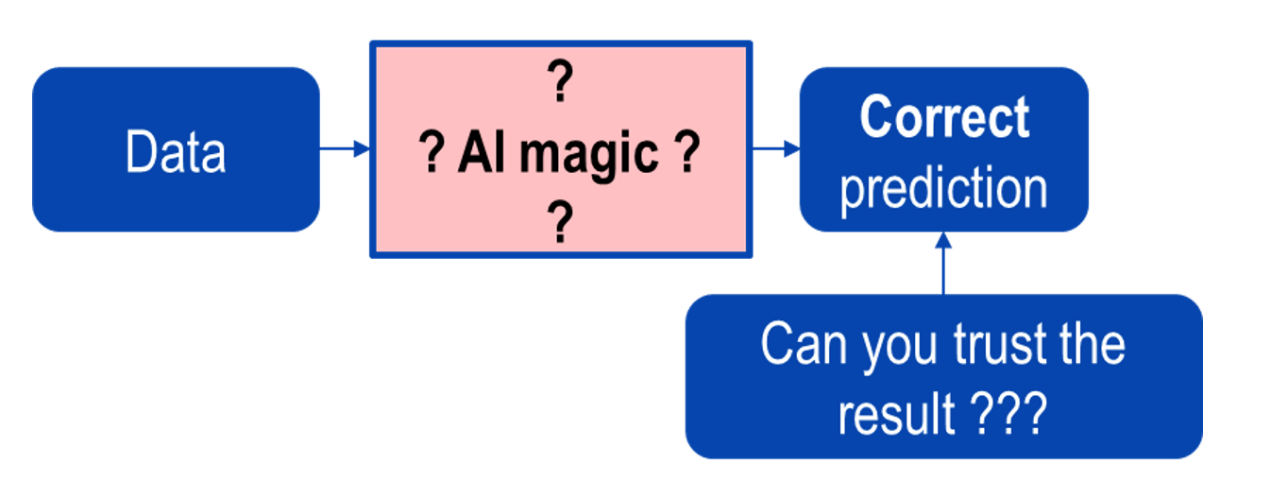

AI——注意黑盒问题

医疗器械所用AI算法的透明度与临床相关。AI模型有着非常复杂和非线性的结构,常常就像“黑盒”一样,也就是很难甚至无法了解它们是如何做出决策的。比如在这个案例中,专家无法确定输入模型数据的哪个部分(例如诊断图像)促使AI做出了判断(例如图片中检测到的癌症组织)。

重构MRT和CT图像的AI方法也被证明在部分情况下不够稳定。输入图像上即便是小小的改变也能导致完全不同的结果。一个原因在于算法的开发有时基于准确度,而没有考虑到稳定性。

如果AI预测不能做到透明且可理解,其医疗决策的正确性就会受到质疑。目前AI在临床前应用中的一些错误进一步加剧了这些怀疑。为确保患者安全,专家必须能够解释AI做出的决策。这是赢得并维持信任的唯一方式。

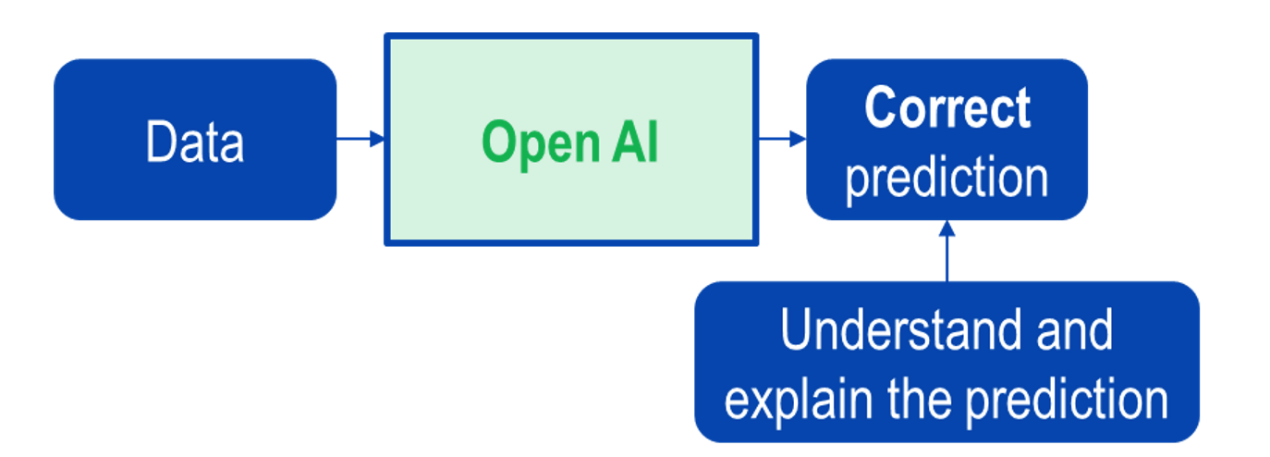

下图说明了黑盒和白盒AI之间的区别。

上图:图3.黑盒AI。

上图:图3.黑盒AI。

上图:图4.开放的黑盒AI。

上图:图4.开放的黑盒AI。

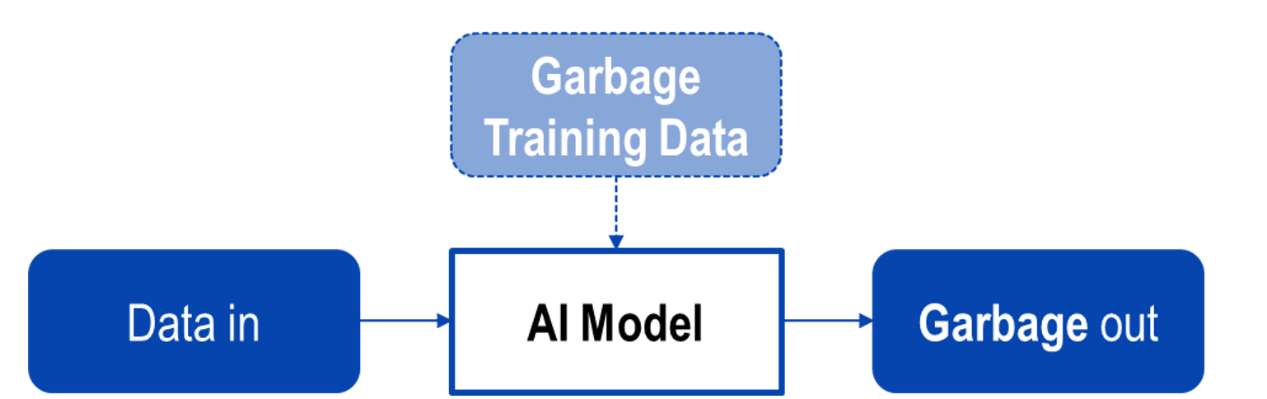

数据质量

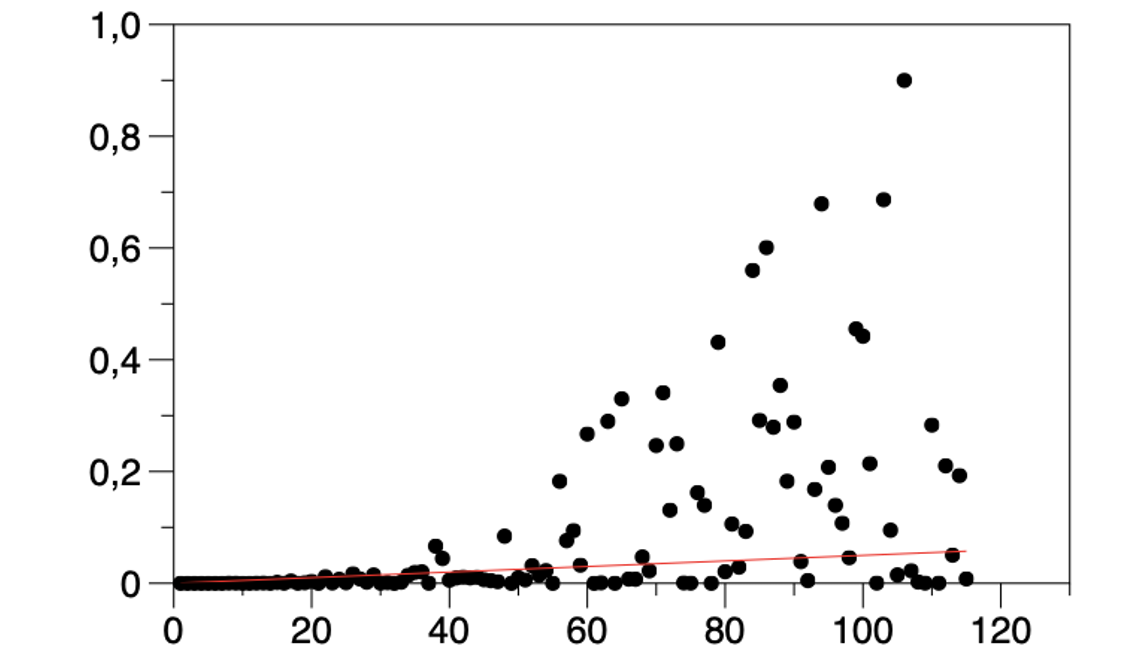

下图显示了使用低质量数据训练AI的结果。示例包括:

• 偏差数据(确定结果类型时出现偏差)

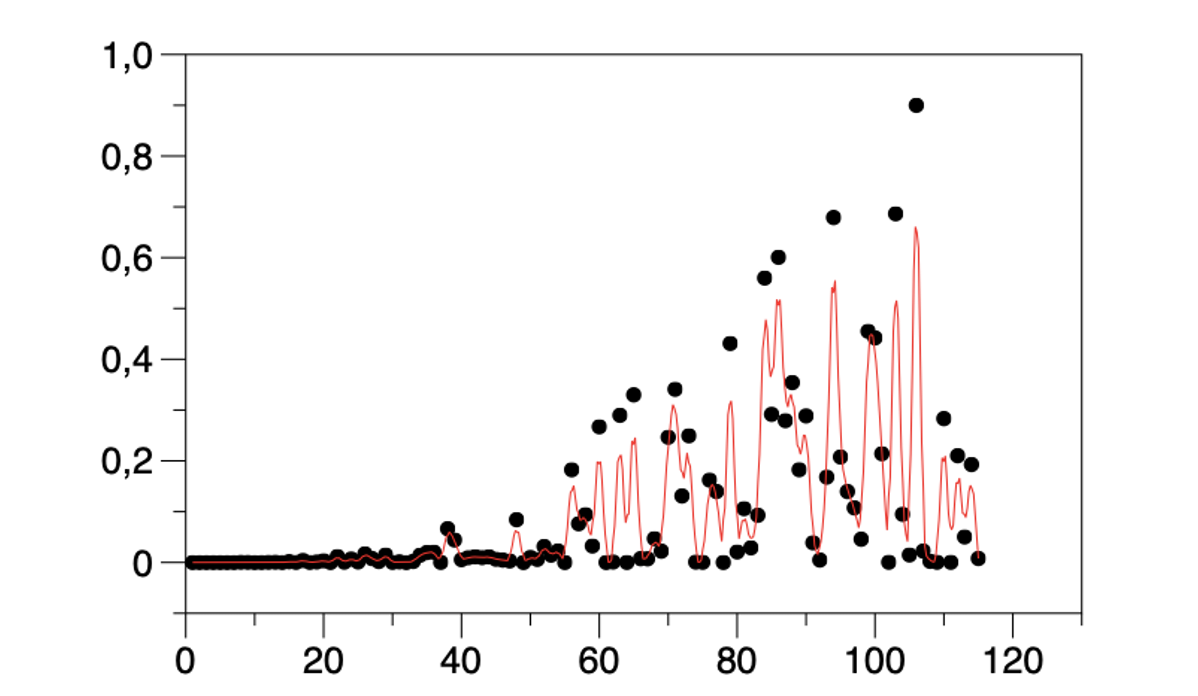

• 过度拟合数据(见图6)包含和过度重视相关性很小或者无关的特性。

• 低度拟合数据:模型不能准确代表训练示例。

上图:图5.使用低质量数据进行训练的结果。

上图:图5.使用低质量数据进行训练的结果。

上图:图6.过度拟合(红线)数据(点)。包含和过度重视相关性很小或者无关的特性。

上图:图6.过度拟合(红线)数据(点)。包含和过度重视相关性很小或者无关的特性。

上图:图7.低度拟合(红线)数据(点)。模型不能准确代表训练示例。

上图:图7.低度拟合(红线)数据(点)。模型不能准确代表训练示例。

开发人员和制造商的免费指南

德国公告机构的利益集团发布的免费检查表为医疗器械列出了150项开发和上市后监管要求(见下方信息框)。在政府发布AI医疗器械安全标准之前,可使用该指南尽量减小医疗AI生命周期中的风险。这有助于以高度规范化的方式为市场引入新技术。